3-1

证明在两类线性分类中,权重向量与决策平面正交

决策平面满足

如果是决策超平面上的两个点,则下式有效:

由于向量的差值位于决策超平面上(对于任意的),所以可以从上式看出权重向量正交于决策平面

3-2

在线性空间中,证明一个点到平面的距离为

设点在平面上的投影为,则

向量与平面的法向量即权重向量平行,则

3-3

在线性分类中,决策区域是凸的。即若点和被分为类别,则点也会被分为类别,其中

基于“argmax"方式

记

有

因为 ,得

即

两式相加,得

即

所以点 也会被分为类别c

3-4

给定一个多分类的数据集,证明:

- 如果数据集中每个类的样本都和除该分类之外的样本是线性可分的,则该数据集一定是线性可分的;

- 如果数据集中的每两个类的样本是线性可分的,则该数据集不一定是线性可分的。

对于任意的样本,都有:

则

故,整个数据集线性可分

3-5

在Logistic回归中,是否可以用去逼近正确的标签,并用平方损失最小化来优化参数?

与题2-1类似

从理论上来说,平方损失函数也可以用于分类问题,但不适合。首先,最小化平方损失函数本质上等同于在误差服从高斯分布的假设下的极大似然估计,然而大部分分类问题的误差并不服从高斯分布。而且在实际应用中,交叉熵在和Softmax激活函数的配合下,能够使得损失值越大导数越大,损失值越小导数越小,这就能加快学习速率。然而若使用平方损失函数,则损失越大导数反而越小,学习速率很慢。

引用自https://zhuanlan.zhihu.com/p/112128809

3-6

在Softmax回归的风险函数(公式3.39)中,如果加上正则化项会有什么影响?

- 减小拟合系数,避免过拟合

3-7

验证平均感知机训练训练算法3.2中给出的平均权重向量的计算方式和公式3.77等价

略

3-8

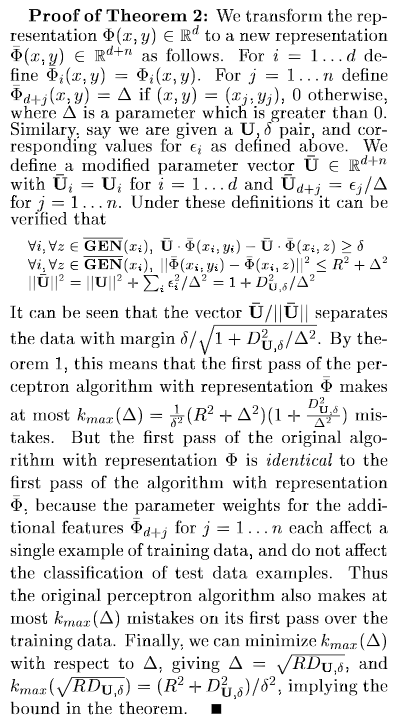

证明定理3.2

3-9

若数据集线性可分,证明支持向量机中将两类样本正确分开的最大间隔分割超平面存在且唯一

略

3-10

验证公式3.97

取特征空间

所以可以取映射

容易验证

3-11

在软间隔支持向量机中,试给出原始优化问题的对偶问题,并列出其KKT条件

略